Многие вебмастера и SEO-специалисты сталкиваются с проблемой индексации сайта, которая серьезно тормозит их SEO-продвижение сайта и снижает трафик. Бывает, что несмотря на постоянные усилия по совершенствованию и оптимизации ресурса, а также добавление нового контента, число страниц в поисковом индексе не растет, а зачастую сайт вообще отсутствует там.

Чтобы найти решение этой проблемы, необходимо выяснить истинные причины, по которым поисковые роботы не могут обнаружить и должным образом проиндексировать ваш проект.

1. Настройки приватности в CMS

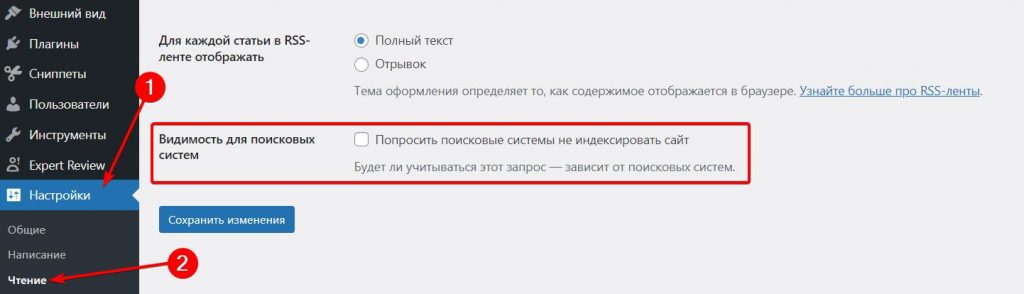

Если вы используете популярную систему управления контентом (CMS) для своего сайта, важно тщательно проверить настройки по умолчанию — зачастую именно они становятся причиной неиндексирования ресурса поисковыми системами.

Например, в CMS WordPress вам необходимо зайти в раздел «Настройки > Чтение» и найти опцию «Видимость для поисковых систем». Убедитесь, что рядом с пунктом «Попросить поисковые машины не индексировать сайт» нет галочки.

Аналогичную проверку стоит провести, если вы используете иную CMS. Довольно часто случается, что вебмастера попросту забывают отключить эту настройку при создании сайта, и в результате их ресурс остается невидимым для поисковых роботов.

Тщательный аудит всех конфигураций CMS, особенно скрытых или установленных по умолчанию, может помочь быстро устранить эту распространенную проблему индексации.

2. Новый сайт

Одной из распространенных причин может быть то, что Яндекс и Google просто еще не заметили ваш новый ресурс. Если вы недавно создали сайт и разместили его в интернете, но не предприняли специальных шагов для его скорейшей индексации, ожидать ее можно долго.

Чтобы этого избежать, я настоятельно рекомендую вам:

- Добавить свой проект в панели веб-мастеров Яндекса и Google

- Создать карту сайта Sitemap.xml и правильный robots.txt

- Указать Sitemap.xml в robots.txt и панели вебмастера поисковых систем

- Добавить страницы на переобход.

Это поможет поисковикам быстрее найти и проиндексировать ваш сайт, обычно в течение нескольких дней, хотя иногда приходится ждать и несколько недель.

В моей статье «Как ускорить индексацию сайта в поисковых системах» вы найдете пошаговую инструкцию по выполнению этих и других важных шагов.

3. Проблемы в robots.txt

Грамотная настройка файла robots.txt — это еще один важный шаг на пути к улучшению индексации и, как следствие, повышению видимости сайта в поисковой выдаче. Не пренебрегайте этим простым, но эффективным инструментом оптимизации.

Проверьте присутствие файла robots.txt на вашем сайте по ссылке https://domen.ru/robots.txt (где domen.ru адрес вашего сайта), если вы видите там такую строку:

Disallow: /То дело плохо, она указывает на то, чтобы поисковые системы не сканировали весь ваш сайт. Удалите слэш в директиве Dissalow, чтобы открыть весь сайт для сканирования.

Если файл не обнаружен, то создайте в корне сайта текстовый файл robots.txt и пропишите в нем:

User-agent: *

Disallow:

Sitemap: https://domen.ru/sitemap.xmlДанная директива указывает всем поисковым системам, что весь сайт можно сканировать.

Если вы хотите указать разделы которые не нужно посещать поисковой системе, то укажите это в директиве Disallow:

User-agent: *

Disallow: /category

Disallow: /feed

Sitemap: https://domen.ru/sitemap.xmlВ строка Sitemap укажите путь к вашей карте сайта в формате xml.

4. Массовые дубли страниц

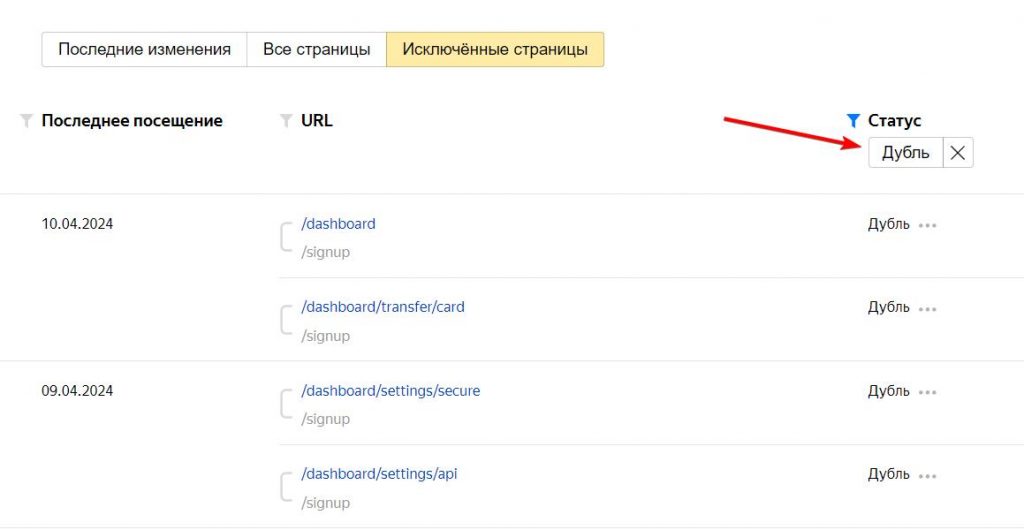

Одной из серьезных проблем может являться массовое дублирование страниц на сайте. Этот фактор не только препятствует правильной индексации ресурса, но и может вызвать применение санкций со стороны поисковых алгоритмов, которые борются с некачественным контентом.

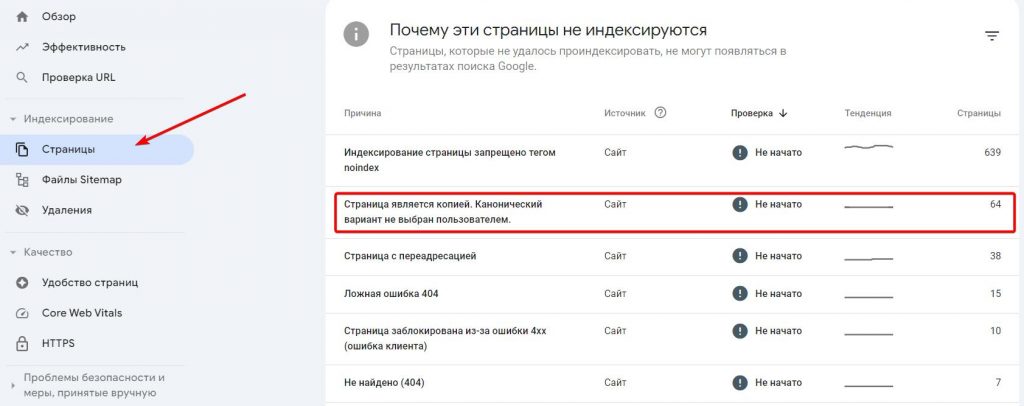

Чтобы выявить основные проблемы, существенно снижающие качество и эффективность вашего проекта, я рекомендую воспользоваться панелями поисковых систем Яндекс.Вебмастер и Google Search Console.

В Яндекс.Вебмастер выбираем свой сайт «Индексирование > Страницы в поиске» нажимаем «Исключенные страницы» и выбираем статус «Дубли».

А в Google Search Console выбираем раздел «Страницы» и жмем на причину «Страница является канонической копией».

Неуникальные страницы являются одной из наиболее распространенных причин, по которым сайты попадают под санкции поисковых систем, что значительно усложняет их продвижение. Поэтому важно регулярно проверять и устранять подобные проблемы для поддержания высокого качества ресурса.

Эти страницы нужно удалять, либо закрывать от индексации.

5. Проблемы с meta robots

В meta robots может быть указан запрет на индексацию страниц вашего сайта. Для подтверждения их присутствия, вам следует просмотреть исходный код веб-сайта и проанализировать содержание на директивы:

<meta name=”robots” content=”noindex, nofollow”>Иногда это правило может быть прописано и для конкретного робота. Например для Яндекс:

<meta name="yandex" content="noindex" />А для Google:

<meta name="googlebot" content="noindex" />Если вы обнаружите указанные строки, то просто удалите их из кода, или замените «nofollow» и «noindex» на «follow» и «index» соответственно.

Должно получиться так:

<meta name=”robots” content=”index, follow”>Таким образом вы указываете всем роботам, что страницу этого сайта можно индексировать.

6. Мета-тег noindex

При проверке кода, обратите внимание и на наличие тега <noindex></noindex>, который может охватывать ваш контент. Этот тег предназначен только для поисковой системы Яндекс и указывает на необходимость исключения содержимого контента из индекса.

Если часть вашего текста заключена в этот тег, страница может быть проиндексирована, но содержимое останется незамеченным поисковыми системами.

7. Проблема с HTTP-заголовком X-Robots-Tag

Этот самый приоритетный способ, который закрывает от индексации страницы от поисковых систем. Сложность в том, что его нельзя увидеть в коде, он отображается на уровне заголовков.

Я написал отдельную статью про X-Robots-Tag, потому что его настройка и отображение имеет множество нюансов, которые нужно учесть и кратко про них не рассказать в этой статье.

8. Проблемы с хостингом

Если поисковый робот заходит на ваш сайт для его индексации, а в это время сайт оказывается недоступным, страницы так и не попадут в базу данных поисковых систем. Поэтому выбор надежного хостинга с высоким уровнем доступности сервера крайне важен.

Для постоянного контроля доступности вашего ресурса существует множество сервисов. Например, «uptime robot».

Также рекомендуем обратить внимание на Яндекс.Метрику — это абсолютно бесплатный инструмент, который поможет вам следить за доступностью вашего сайта.

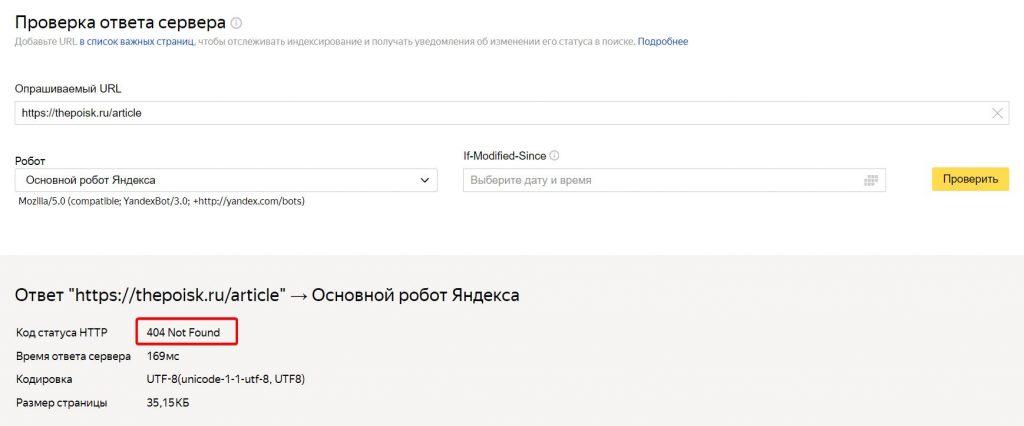

9. Ответ сервера 404 или 410

Ответы сервера 404 и 410 могут привести к серьезным проблемам с индексацией вашего проекта поисковыми системами. Когда поисковый робот обращается к вашему серверу и получает ответ 404 (страница не найдена) или 410 (страница удалена навсегда), он не может проиндексировать этот контент. Это может привести к потере трафика и позиций в поисковых результатах.

Чтобы проверить наличие страниц с ответом сервера 404 или 410, можно воспользоваться различными инструментами. Один из самых популярных способов — использовать инструменты вебмастера, предоставляемые поисковыми системами, такими как Google Search Console или Яндекс.Вебмастер. Они позволяют обнаруживать страницы с ошибками и принимать меры для их исправления.

Кроме того, можно воспользоваться отдельным онлайн-сервисом от Яндекса, чтобы проверить отдельную страницу на ответ сервера.

Или сканерами сайтов, например Screaming Frog или Site Analyzer — эти программы могут провести полное сканирование вашего проекта и выявить страницы с ошибками 404 и 410, а также другие проблемы, которые могут повлиять на индексацию и SEO вашего сайта.

10. Плохая история домена

Хотя новый домен может звучать привлекательно, но важно быть готовым к тому, что его предыдущий владелец мог применять недобросовестные методы продвижения или запрещенный контент. Это может привести к наследованию ряда проблем, которые вам теперь придется решать самим.

Для улучшения ситуации можно:

- Обратиться в Яндекс и Google с запросом на пересмотр, чтобы выяснить причины непроиндексированных страниц.

- Продолжать продвигать проект и постоянно работать над его качеством, устраняя недостатки.

Имейте в виду. Если через три или более месяцев ваш сайт все еще не проиндексирован должным образом, то может быть целесообразно рассмотреть вариант смены доменного имени. Также стоит обратиться в поддержку поисковых систем для выяснения возможных санкций, наложенных на данный домен, если они не отображаются в панелях вебмастера.

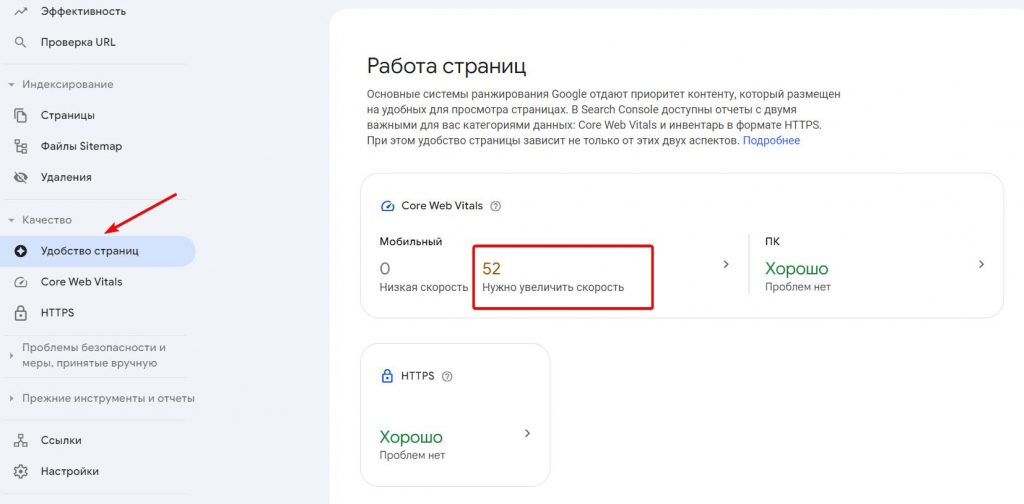

11. Медленная скорость загрузки сайта

Данный показатель является факторов ранжирования ресурса и может оказывать существенное влияние на его позиции в поисковых системах. Разумеется, если ваш проект загружается дольше положенного, с большой долей вероятности и его индексация будет проходить очень медленно.

Скорость загрузки сайта зависит от множества факторов, включая:

- Хостинг. Качество хостинга и его производительность имеют огромное значение. Быстрая и стабильная работа сервера способствует быстрой загрузке сайта.

- Оптимизация изображений. Крупные и неоптимизированные изображения могут существенно замедлить загрузку страниц. Используйте форматы изображений с поддержкой сжатия без потери качества.

- Кэширование. Использование кэширования помогает уменьшить время загрузки, так как браузер может сохранять копии ресурсов на компьютере пользователя.

- Минимизация и объединение файлов CSS и JavaScript. Уменьшение количества и размера файлов CSS и JavaScript позволяет ускорить загрузку страницы.

- Использование CDN. Сети доставки контента (CDN) помогают ускорить загрузку сайта, распределяя его контент по серверам по всему миру и обеспечивая более быстрый доступ к ресурсам.

- Оптимизация кода. Чистый и эффективный код без избыточных элементов способствует более быстрой загрузке страниц.

- Минимизация запросов к серверу. Сокращение количества запросов к серверу (например, к базе данных) помогает ускорить загрузку сайта.

- Оптимизация критического контента. Загрузка критически важного контента вначале помогает пользователям видеть содержимое страницы быстрее.

Проблемы со скоростью сайта могут отображаться в панелях поисковых систем Яндекс.Вебмастер и Google Search Console. Если у вас серьезные проблемы со скоростью, то в Яндекс.Вебмастере вы увидите эту фатальную ошибку на главном экране.

В Google Search Console проблемы могут отображаться в показатели Core Web Vitals, который находится на вкладке «Удобство страниц». Здесь этот показатель делится на мобильную и ПК версию.

12. Ресурс заблокирован в файле htaccess

Зачастую данный файл используется для настройки 301 редиректа, однако здесь также можно осуществить закрытие поисковым ботам доступ к сайту. Чтобы проверить содержимое .htaccess, найдите его на сервере, после чего проверьте код, чтобы там не было команд, блокирующих ресурс. Например, таких:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_botЕсли вы не разбираетесь в настройке .htaccess, то советую обратиться к поддержке хостинга на котором размещен ваш проект и попросить их проверить этот файл на запрещенные команды.

13. Наличие AJAX и JavaScript

Использование технологий, таких как Ajax и JavaScript, может создавать некоторые проблемы с индексацией сайтов поисковыми системами.

Вот почему:

- Асинхронная загрузка контента. Ajax позволяет загружать контент асинхронно, без перезагрузки всей страницы. Это может привести к тому, что поисковые роботы не увидят этот контент во время индексации, так как они не выполняют JavaScript.

- Неиндексируемые ссылки. Если ссылки на другие страницы загружаются динамически с использованием JavaScript, они могут быть упущены поисковыми системами при индексации.

- Неотображаемый контент. Некоторый контент может быть скрыт или загружен только после выполнения определенных действий пользователем с помощью JavaScript. Поисковые роботы не увидят этот контент и, следовательно, не смогут проиндексировать его.

Чтобы уменьшить эти проблемы и обеспечить более полную индексацию вашего сайта поисковыми системами, следует:

- Предоставить альтернативный контент. Предоставьте понятный и доступный контент для поисковых роботов в HTML-разметке, даже если основное содержимое загружается динамически.

- Использовать prerendering. Используйте техники prerendering или server-side rendering, чтобы предоставить поисковым системам полностью отрендеренную версию вашего сайта.

- Убедиться в доступности контента. Убедитесь, что весь контент доступен для индексации с помощью стандартного HTML и CSS, без необходимости выполнения JavaScript.

14. Попадание под фильтры поисковиков

Получить Deindexed, пожалуй, страшнее всего. Это наказание за то, что вебмастер или SEO-специалист нарушил правила и выбрал запрещенные способы продвижения своего сайта.

Например:

- Покупка ссылок. Манипулятивная покупка ссылок для искусственного увеличения рейтинга может привести к серьезным санкциям от поисковых систем.

- Загрузка скрытого контента. Представление контента, который не виден обычным пользователям, но доступен для поисковых роботов, может привести к блокировке или понижению рейтинга сайта.

- Использование недобросовестных методов SEO. Это может включать в себя заполнение ключевыми словами, автоматизированные средства создания ссылок, дублирование контента и другие манипуляции, направленные на обман поисковых алгоритмов.

- Спам на форумах и блогах. Активное размещение низкокачественных комментариев с ссылками на свой сайт в целях продвижения может быть воспринято поисковыми системами как спам и привести к санкциям.

- Нарушение авторских прав. Публикация контента без разрешения владельца авторских прав может привести к юридическим проблемам и санкциям со стороны поисковых систем.

Часто нарушения могут зависеть не от вас. Например, если ваш сайт был взломан и использован для размещения вредоносного контента или ссылок, поисковые системы все равно могут его удалить из своих результатов поиска.

Если вы попали под санкции или фильтр поисковых систем, то вернуть сайт в поиск может быть очень сложно, в зависимости от серьезность вашего нарушения. В любом случае, напишите в поддержку поисковой системы и узнайте, как исправить ситуацию.

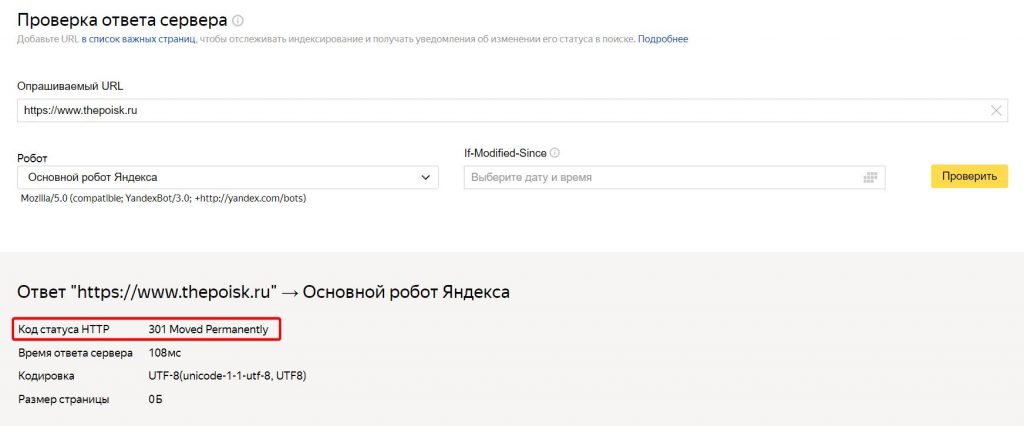

15. Индексация сайта с www и без www, http и https

По факту, для поиска версия сайта с www является поддоменом для версии без www. Поэтому для поисковой системы https://thepoisk.ru и http://www.thepoisk.ru — это разные адреса сайта.

Перепроверьте, указали ли вы 301 редирект с одного домена на другой:

Аналогичная ситуация и для протоколов http и https. Если ваш сайт имеет версию для https, то вы должны сделать 301 редирект со всех страниц сайта с http на https.

Основные выводы

Без индексации веб-сайта его существование просто бессмысленно, только если вы не ведете его чисто для себя. Если желаете продвигать сайт, найдите причину, из-за которой он не появляется в индексе поисковой системы. Это важно, чтобы поскорее предотвратить проблему и в дальнейшем не допускать ее снова.

Основной индикатор проблем с индексацией всегда будет указан в панелях Яндекс.Вебмастер и Google Search Console. Поэтому первым делом проверяйте их на наличие ошибок.

Если же вы исправили все вышеуказанные причины и ресурс все-равно не попадает в поиск, незамедлительно обращайтесь в поддержку Google и Яндекс. Там вам с большой вероятностью объяснят, в чем дело.

Основные вопросы и ответы про проблемы индексации

Собрал популярные вопросы про индексацию сайта и страниц, которые мне задают на консультациях. Привожу, краткие ответы.