Практически каждый вебмастер и SEO-специалист, особенно на начальном этапе создания проекта, сталкивался с необходимостью удаления страниц веб-сайта из индекса поисковиков. Даже не взирая на то, что процедура, на первый взгляд, довольно простая, но в ней есть некоторые важные нюансы.

Зачем нужно удалять страницы из индекса?

Порой владельцу веб-ресурса приходиться скрывать документ от поисковиков по следующим причинам:

- сайт находится в стадии разработки и попал в выдачу совершенно случайно;

- контент на странице больше неактуален;

- проиндексированная страница дублирует другую страницу, которая уже есть на сайте;

- в индекс попали служебные страницы, где размещены личные данные клиентов.

Во избежание таких случаев, я расскажу об эффективных и правильных способах удаления страницы из индекса поисковых систем.

С помощью панелей поисковых систем

Данный метод удаления страницы сайта для поисковых роботов считается одним из самых эффективных. Этот инструмент идеально подходит для тех случаев, когда определенные URL нужно удалить срочно и в самое короткое время.

Яндекс

Для этого вам понадобится сервис Яндекс.Вебмастер. Если вы не добавляли свой сайт в эту панель, то нужно это сделать. Перейти в свой сайт.

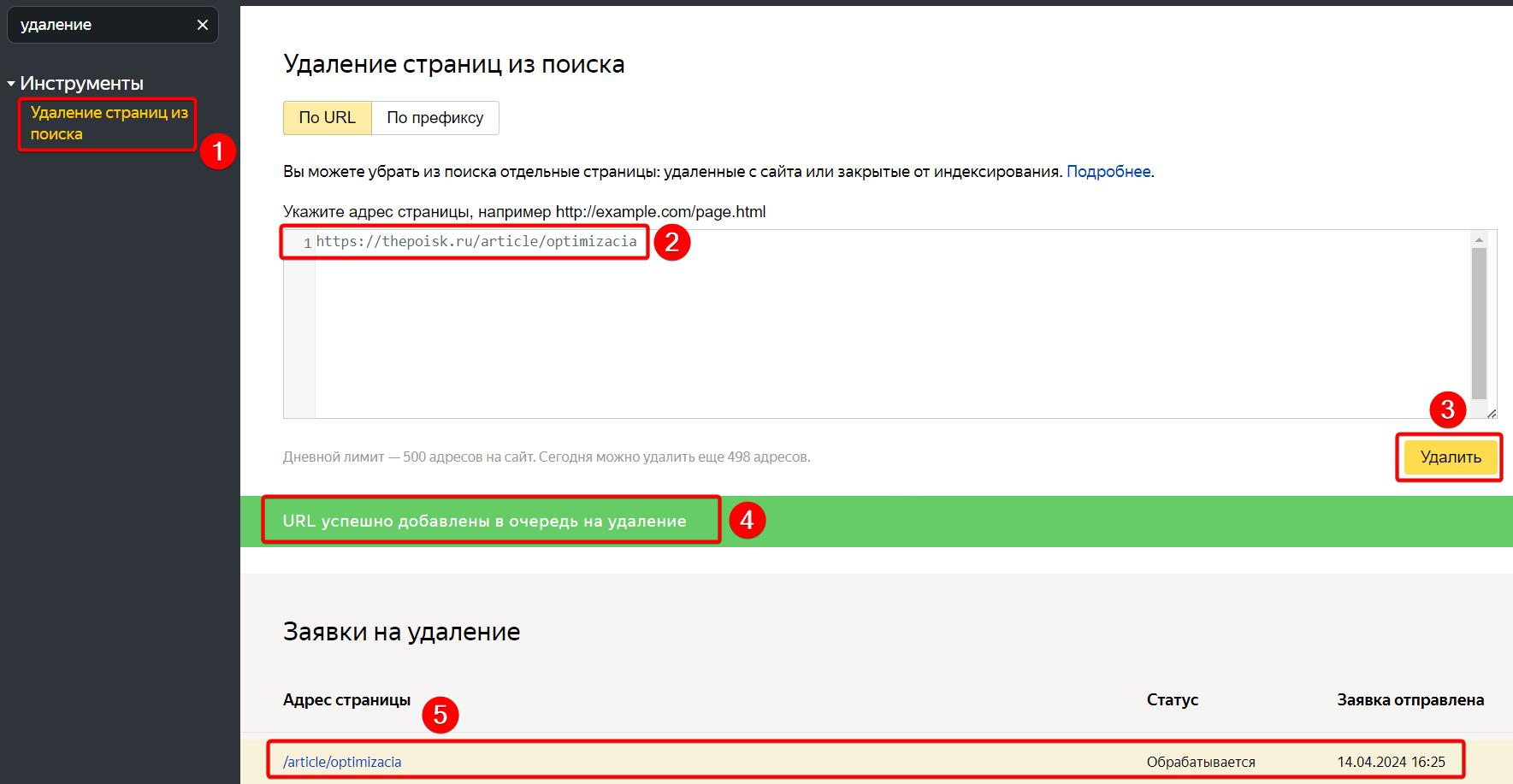

- Открыть вкладку «Инструменты > Удаление страниц из поиска»

- В поле ввести URL, который нужно удалить

- Нажать на кнопку «Удалить»

- После успешной отрпавки URL на удаление, вы увидите соответствующее сообщение.

- Заявка и статус удаления отобразится под формой ввода URL.

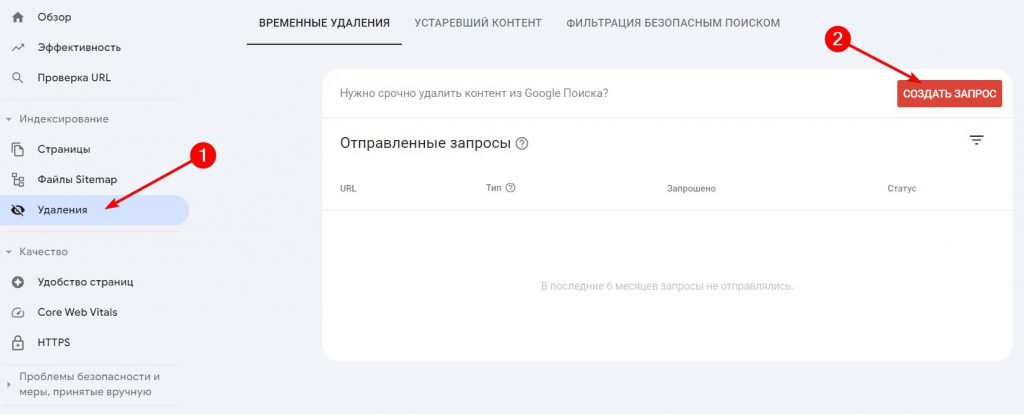

Авторизируйтесь на площадке Google Search Console. Предварительно добавьте свой сайт в панель, если вы еще этого не сделали.

Затем найдите вкладку «Удаления» и нажмите «Создать запрос».

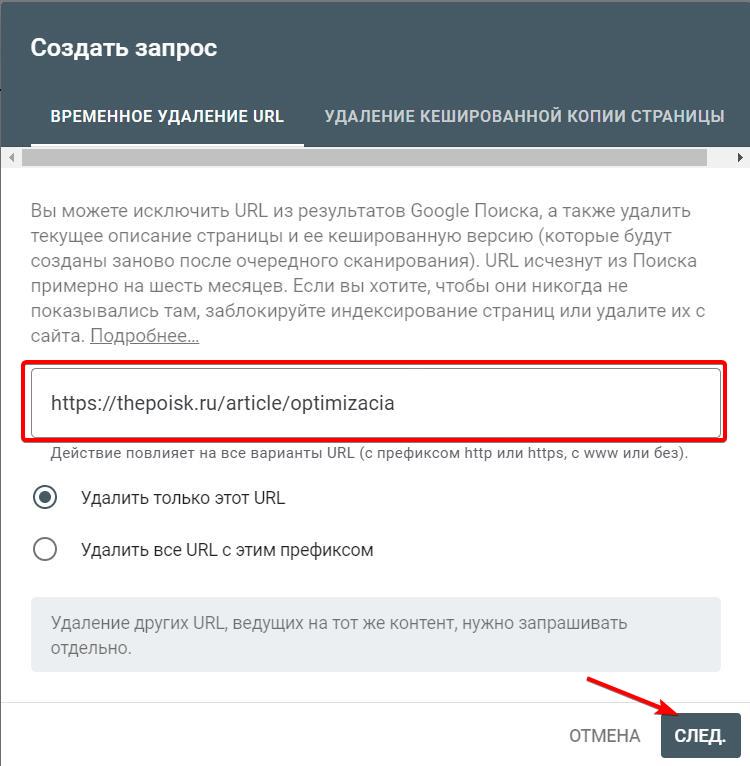

В появившемся окне убедитесь, что отмечена опция «Удалить только этот URL», укажите в поле адрес удаляемой страницы. Затем отправьте запрос нажав на кнопку «След.».

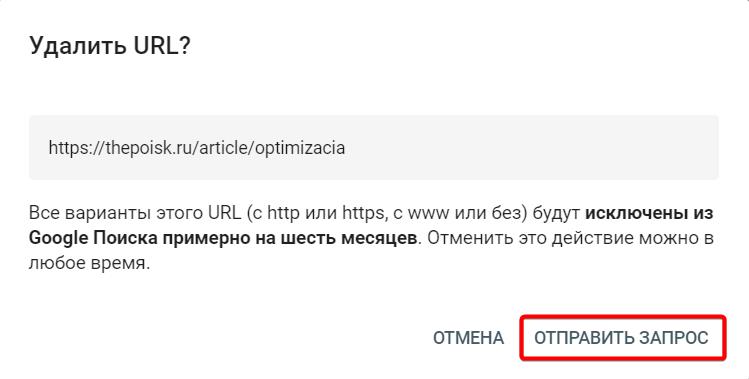

Появится еще одно сообщение в котором нужно нажать «Оправить запрос».

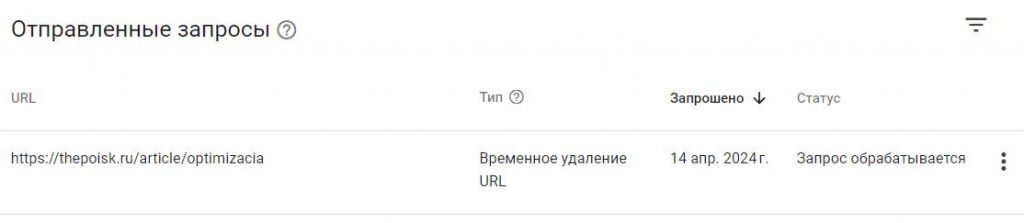

Указанный URL будет добавлен в очередь на удаление и вы его увидите в таблице. И теперь вам остается только ждать.

Зачем закрывать страницы от индексации

Нужно понимать важный нюанс, если вы удалили страницу из индекса через панели поисковых систем, а она до сих пор доступна на вашем сайте или отдает ответ сервера 200. То через некоторое время робот поисковых систем проиндексирует ее снова.

Поэтому перед удалением страницы вам нужно предварительно закрыть ее от ботов через мета-тег robots, статус x-robots-tag или сделать так, чтобы сервер отдавал 404 ошибку для этой страницы. Ниже разберем все эти нюансы.

Ошибка 404 на сервере

Наверняка каждый пользователь, ища нужную информацию в Интернете, попадал на страницу, где выдавало ошибку 404 – «Страница не найдена». Это значит, что искомый по вашему запросу документ был удален с ресурса.

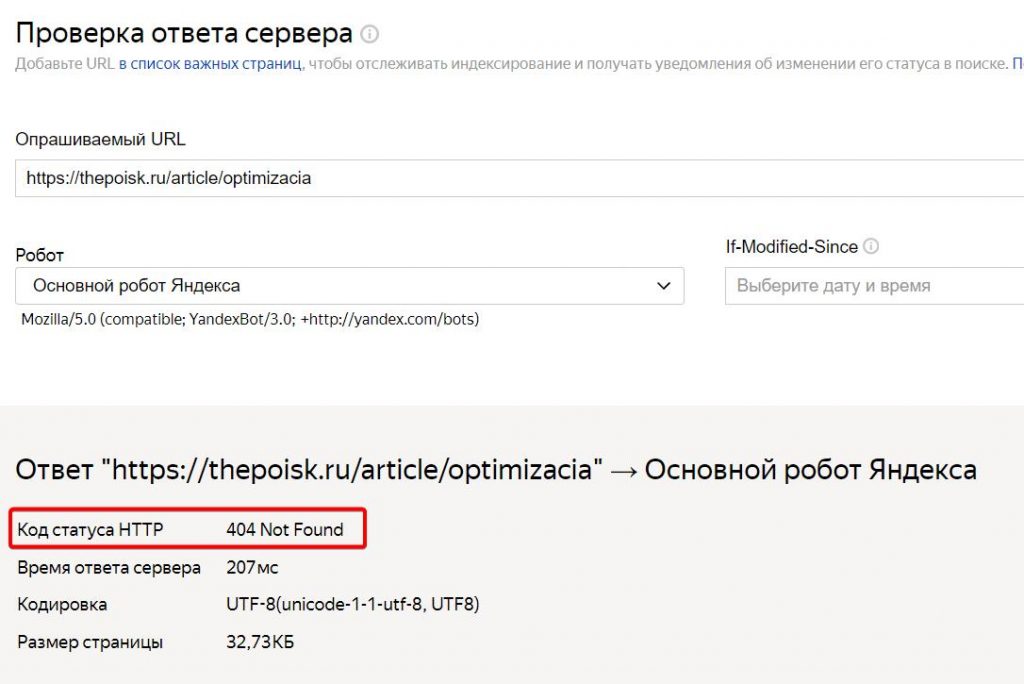

Сделать это вебмастер может в панели управления сайтом, например, в CMS WordPress. Вы просто удаляете страницу из админ панели сайта и она автоматически отдает ответ сервера 404. Чтобы проверить, какой ответ сервера отдает страница, можно воспользоваться сервисом Яндекса.

Для поисковиков 404 ошибка означает, что вы настраиваете ответ сервер этой страницы так, чтобы на определенном адресе появился код 404 not found. И когда робот снова посетит данный URL, сервер сообщит ему, что страницы больше нет. Это дает понять поисковикам, что документ удален с сайта, и они уберут его из поисковой выдачи, чтобы посетители больше не заходили на него.

К характерным особенностям данного способа можно отнести:

- Простую настройку всего за несколько кликов.

- Полное исчезновение страницы с сайта. Из-за этого не рекомендуется использовать данный метод в случае, когда из индекса нужно убрать служебную страницу (конфиденциальную информацию клиентов и пр.).

- Также стоит прибегнуть к другому варианту скрытия страницы, например, 301 редирект, если на нее ведут входящие ссылки.

Важно! Страница выпадает из поискового индекса не за счет ее удаления с ресурса, а за счет дальнейшей переиндексации. Поэтому для ускорения ее удаления из индексации вам нужно будет воспользоваться первым способом и добавить URL в сервисы поисковых систем. Таким способом страница быстро удалится и больше не появится в выдаче поисковой системы, потому что будет отдавать ошибку сервера 404, что говорит поисковым система — страницы больше не существует.

Для вебмастеров такой метод является одним из самых удобных, а вот посетителю ошибка 404 может не понравиться, и есть риск того, что пользователь, увидев ее, перестанет заходить на сайт. Но выход есть и из этой ситуации.

На заметку. Очень часто сайтостроители занимаются интересным оформлением страницы, на которой показывается ошибка 404 not found. Они выкладывают туда полезную информацию и предлагают посетить другие страницы ресурса, которые непременно привлекут внимание посетителя. Так вы сделаете эту страницу более привлекательной для пользователя, что может положительно на перенаправлении пользователя на другую страницу вашего сайта. Либо вместо 404 ошибки, можно сделать 301 редирект, тогда пользователь будет перенаправлен на указанную страницу.

Запрет в файле robots.txt

Еще один распространенный метод, к которому прибегают вебмастера и оптимизаторы. Он позволяет скрыть отдельные документы и целые разделы от сканирования роботами поисковых систем.

В файле robots вы можете не только запретить, но и разрешить поисковым ботам посещать сайт или определенные страницы. Подобные команды обеспечиваются применением директивы Disallow.

Для запрета сканирования страниц, вам нужно получить доступ к корневой папке сайта и создать файл robots.txt, либо отредактировать существующий, если он уже создан.

В документе robots.txt в основном содержатся 2 строки:

- User-agent. Здесь указывается имя робота определенного поисковика, которому вы запрещаете сканировать страницу, или же прописывается директива User-agent: *, которая применяется сразу для всех ботов.

- Disallow. Тут прописывается URL страницы или целого раздела, который рекомендуется не посещать роботу поисковой системы.

Вместе они создают команду для поисковых машин, касающуюся указанного URL. Если требуется, вы можете в одном файле скрыть сразу несколько страниц на одном ресурсе, и они никак не будут влиять друг на друга.

Например, вот так мы укажем всем поисковым роботам, чтобы они не сканировали страницы index и password на нашем сайте

User-agent: *

Disallow: /index

Disallow: /passwordКогда вы пропишите данную команду, нужно будет ждать следующей индексации. Вам стоит знать, что все изменения в файле robots несут для поисковиков рекомендательный характер, поэтому не удивляйтесь, если страница по-прежнему останется в индексе. Но если через определенный промежуток времени статус документа не изменится, он все же будет удален из базы данных поисковых систем.

Важно знать! Команды в файле robots.txt не удаляют страницы с сайта, они просто указывают поисковым системам, чтобы они не переходили на эту страницу. Поэтому если вы запретите в robots.txt определенную страницу, и удалите ее с сайта (она будет отдавать 404 ошибку). Но робот не сможет просканировать ее и узнать, что страница отдает ответ сервера 404. Поэтому она еще долго будет оставаться в индексе. В robots.txt нужно запрещать страницы, которых уже нет в индексе поисковых систем.

Мета-тег Robots

Данный способ более приоритетнее, чем указания в robots.txt.

Команды на запрет прописываются в html-коде сайта внутри тегов head:

<meta name =“robots” content=”noindex,nofollow” />Мет-тег robots — отличный вариант тогда, когда вам нужно закрыть страницу от индекса Яндекса, но при этом оставить ее доступной в Google.

Пример закрытия URL только для Яндекса:

<meta name=”yandex” content=”noindex,nofollow”>X Robots Tag

Использование X-Robots-Tag HTTP-заголовка является одним из наиболее эффективных способов удаления страницы из индекса поисковых систем:

- X-Robots-Tag позволяет напрямую сообщать поисковым ботам, как обрабатывать страницу. Это дает более четкие и надежные сигналы, чем косвенные методы, такие как meta robots и robots.txt.

- Директивы X-Robots-Tag имеют более высокий приоритет, чем любые другие сигналы на странице. Это гарантирует, что поисковые системы будут точно следовать вашим инструкциям по удалению страницы.

- Применение X-Robots-Tag не требует изменения HTML-кода страницы. Достаточно добавить заголовок HTTP в ответ сервера.

В этом способе очень много нюансов, поэтому я написал про него отдельную статью.

Выводы

Если вы хотите, чтобы страница была доступна на сайте, но ее не было в индексе:

- Указываете на странице X-Robots-Tag, либо прописываете на странице meta robots на запрет индексации.

- Удаляете страницу с помощью сервисов поисковых систем Яндекс Вебмастер и Google Search Console.

Если вы удаляете страницу с сайта и она на нем уже не доступна:

- Проверьте, что страница отдает ответ сервера 404 или 410

- Удаляете страницу с помощью сервисов поисковых систем Яндекс Вебмастер и Google Search Console.

Как быстро страница удалится из индекса

Время, необходимое для полного удаления страницы, может варьироваться в зависимости от ряда факторов.

Во-первых, важно отметить, что каждая поисковая система имеет свои собственные алгоритмы и временные рамки для обновления своего индекса. Например, Яндекс может быстрее реагировать на запросы удаления, чем Google.

Использование функции удаления URL в панели вебмастера поисковой системы является наиболее эффективным способом удаления страницы. Этот метод обычно занимает от нескольких часов до нескольких дней, в зависимости от загруженности системы и приоритета, который поисковая система придает вашему сайту.

С другой стороны, использование директив «robots meta noindex» в теге HTML или ответа сервера 404 может занять больше времени, поскольку поисковые системы должны повторно проиндексировать страницы, чтобы обнаружить эти директивы и ответ сервера. Этот процесс может занять от нескольких дней до нескольких недель в зависимости от частоты, с которой поисковые системы посещают ваш сайт.

В целом, время, необходимое для удаления страницы из индекса поисковых систем, зависит от выбранного метода и приоритета, который поисковая система придает вашему проекту.

Вопросы и ответы по удалению страницы из индекса

Собрал список вопросов, которые мне часто задают на консультации про удаление страниц из индекса. Привожу краткие ответы.

Доброго времени суток)!

Удалил свою анкету с сайта, но она продолжает появляться в поисковике. Что делать?

Если вы про сторонний сайт говорите, то ждать когда она переиндексируется и удалится.

мне нужно удалить несколько страниц чужих сайтов с поискового индекса

это возможно?

С чужого нет. Если только написать владельцу сайта и попросить сделать это.

Спасибо за ответ.

мне владелец сказал,что через две-ти недели со временем пропадет сама

но прошло три месяца, а в результатах поиска все так же отображается

Владелец может удалить через панели вебмастера, будет быстрее. Скиньте ему эту статью. Так же страница должна отдавать ответ сервера 404 или 410.